“هناك احتمال ١٠٪ أو أكبر للانقراض البشري بسبب الذكاء الاصطناعي.”

نتيجة استفتاء أكثر من ٧٠٠ مختص في الذكاء الاصطناعي

يُسمي مختصون الذكاء الاصطناعي فترة الستينات من القرن الماضي ( العصر الذهبي للذكاء الاصطناعي ). فأثناؤها تم ابتكار العديد من أفكاره الجوهرية، وتسابقت حينها الجامعات الأمريكية، مثل MIT وستانفورد و كارنيغي ميلون، في إجراء الأبحاث بالتحالف مع الشركات الكبرى، كما قدمت مختلف الجهات العسكرية الدعم والتمويل.

تزايد الحماس حتى غمر غير المختصين، وتكلل بإصدار فيلم ( ٢٠٠١: أوديسة الفضاء ) في سنة ١٩٦٨ للمخرج ستانلي كوبرك، والذي غرس فكرة الذكاء الاصطناعي في الوعي والخيال الجمعي من خلال شخصية ( HAL 9000 ) بصوتها الجذاب والمرعب في الوقت ذاته.

لكن مع بداية السبعينات بدأت الرياح تهب في اتجاه مختلف. يطلق الباحثون على حقبة السبعينات والثمانينات اسم ( شتاء الذكاء الاصطناعي ). الاسم يقصد به التشبيه بالشتاء النووي، وهو السيناريو التخيلي المدمر الذي يعقب استخدام السلاح النووي، ويتسبب بمضاعفات بيئية كارثية.

لكن ما سبب هذه التسمية بالغة التشاؤم والسوداوية؟

السبب أنه خلال تلك الفترة مرّ الذكاء الاصطناعي بأحلك أوقاته. فقد انخفض دعمه بشكل حاد، وقل حماس الجامعات والشركات، وتولدت حالة من الإحباط في أوساط المتحمسين والمهتمين به. كان هناك قناعة بأنه لم يفِ بوعوده، ولم يحقق أهدافه، ولم يقدم نتائج توازي ما صرف عليه. ففي تقرير نشر عام ١٩٧٣ من مجلس البحوث العلمي البريطاني تم وصف نتائج الاستثمار في الذكاء الاصطناعي بأنها ” أسوأ خيبة أمل .. نتائج ضئيلة النفع مقارنة بميزانيات طائلة.”

استمر هذا الشتاء حتى التسعينات، ثم بدأت الأمور تتحسن، وخصوصا بعد انتصار نظام IBM Deep Blue على أفضل لاعب شطرنج في التاريخ، غاري كاسباروف.

” أنا في نهاية الأمر مجرد إنسان. عندما أرى شيئاً يتجاوز قدرتي على الاستيعاب فإني أرتعب.”

تصريح أفضل لاعب شطرنج في التاريخ (غاري كاسباروف ) بعد هزيمته من الذكاء الاصطناعي

بعد مرور أكثر من ٢٠ سنة على انجلاء شتاء الذكاء الاصطناعي، نشر ( نيلز نلسون )، أحد رواد الذكاء الاصطناعي، كتاب بعنوان ( السعي للذكاء الاصطناعي ) يرصد فيه تاريخ الذكاء الاصطناعي، ويتحدث عن حالة الإحباط منه في تلك الفترة، والتي ترافقت مع عدم تحقيقه النتائج المتوقعة حينذاك.

في الكتاب ذكر المؤلف نقطة في غاية الأهمية.

يقول إنه بلا أدنى شك أن جزءًا كبيراً من اللوم يقع على عاتق العلماء والباحثين في مجال الذكاء الاصطناعي الذين بالغوا وهولوا ورفعوا سقف التوقعات لدرجة غير منطقية مما أدى إلى اصطدام العديد من الشركات والجهات الحكومية بالواقع.

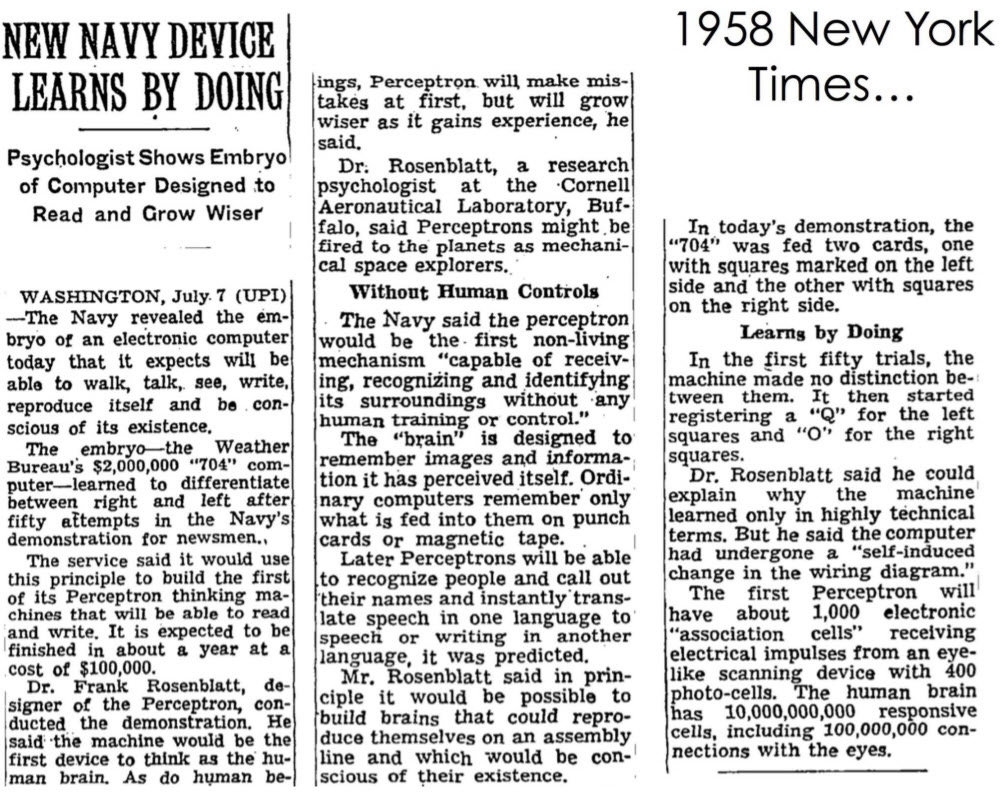

هذه المبالغات لم تتدرج، بل انطلقت مباشرة بعد الانتهاء من بناء أول نظام لتعلم الآلة اسمه Perception. صرّح حينها الباحث لصحيفة النيويورك تايمز أنه قريبا ستتمكن الحواسيب من التحدث والمشي والتكاثر (نعم قال التكاثر 😂) وستكون واعية، وسنتمكن من إرسالها في رحلات فضائية. حتى تتصور حجم مبالغة هذا الادعاء، فبعد سنوات قليلة تمكن باحثون في جامعة ستانفورد من بناء نظام ذكاء اصطناعي اسمه ( مادلين ). هذا النظام يعتبر أول نظام يستطيع حل مشكلة حقيقية يحتاج المجتمع لحلها. النظام كان ناجحاً لدرجة أن استخدامه استمر لعدة عقود .. لكن هل تعرف فائدته؟ .. لم يكن استكشاف الفضاء ولا التكاثر .. كان فقط قادراً على محو الصدى من المكالمات الهاتفية.

التاريخ الآن يعيد نفسه

“أولئك الذين لا يستطيعون تذكّر الماضي محكوم عليهم بتكراره.”

حالياً نعيش حالة من الفوضى والضجيج والاندفاع نحو تطوير أنظمة ذكاء الاصطناعي، دون أي مراعاة لمخاطرها المحتملة وهو ما سوف يؤدي في نهاية المطاف لعودة شتاء جديد للذكاء الاصطناعي، بل إنه قد يؤدي لنتائج تدميرية على مستوى البشرية. ففي دراسة تمت سنة ٢٠٢٢، سُئل أكثر من ٧٠٠ من كبار الأكاديميين والباحثين في شركات الذكاء الاصطناعي الرائدة عن مستقبله. قال نصفهم أن هناك احتمال ١٠٪ أو أكبر للانقراض البشري بسببه. تخيل معي أنك على وشك السفر بالطائرة في رحلة طويلة، وبعد إعلان فتح بوابة الطائرة اقترب منك مجموعة من المهندسين الذين صمموا الطائرة، وأكدوا لك أن هناك نسبة لا تقل عن ١٠٪ أنها ستقع، هل سوف تركب الطائرة؟

هذا ما دعى مئات الخبراء في شهر مارس الماضي لكتابة وتوقيع رسالة مفتوحة تدعو إلى التوقف لمدة ستة أشهر عن تطوير أنظمة الذكاء الاصطناعي التي تعادل أو تزيد عن قوة الجيل الرابع من نظام GPT حتى يتسنى تطبيق بروتوكولات تضمن الأمان والسلامة. اُفتتحت الرسالة بالجملة المرعبة التالية: “إن الكثير من الأبحاث تؤكد أن أنظمة الذكاء الاصطناعي التي تصل لمستوى ذكاء الإنسان باستطاعتها أن تشكَّل مخاطر جسيمة على البشرية والمجتمع.” هذه الجملة ليست تخميناً، أو مبالغة، أو خيالاً جامحاً، هذه الجملة حقيقة أقرها ووقع عليها عدد كبير من سدنة الذكاء الاصطناعي حول العالم.

ناشدت الرسالة الحكومات والشركات بالتركيز على بناء أساس قوي لصناعة الذكاء الاصطناعي يأخذ في الاعتبار مخاطرها وفوائدها، بدلاً من التسابق المحموم نحو تطوير أنظمة أكثر تطوراً دون أدنى مراعاة للمخاطر المحتملة. لضمان أمان وسلامة أنظمة الذكاء الاصطناعي يجب أن تتعاون الشركات مع خبراء مستقلين في تنفيذ بروتوكولات تسمح بتطوير أنظمة الذكاء الاصطناعي تحت تدقيق وإشراف محكمين خارجيين. بالإضافة لذلك، يجب تطوير أنظمة حوكمة قوية وتمويل أبحاث السلامة للذكاء الاصطناعي.

أحيانا، يُردَّد بأن حدة التنافس بين الشركات والدول ( وخصوصا بين الولايات المتحدة والصين ) لن تسمح بتنفيذ هذا المقترح. هذا تحليل مجانب للصواب، لأن نشر أنظمة الذكاء الاصطناعي والسماح بتداخلها مع مؤسسات وأفراد المجتمع دون أي تحكم أو مراقبة سيكون السبب الرئيسي والمباشر في خسارة سباق التطور. من يريد أن يكسب السباق يجب أن يكون أول الداعين لهذا التوقف المؤقت.

“السباق للسيطرة على السوق لا ينبغي أن يحدد سرعة انتشار أهم تقنية في تاريخ البشرية. يجب أن يتم تطوير الذكاء الاصطناعي برتم يمكننا من السيطرة عليه.”

يوفال هراري (أحد الموقعين على الرسالة المفتوحة)

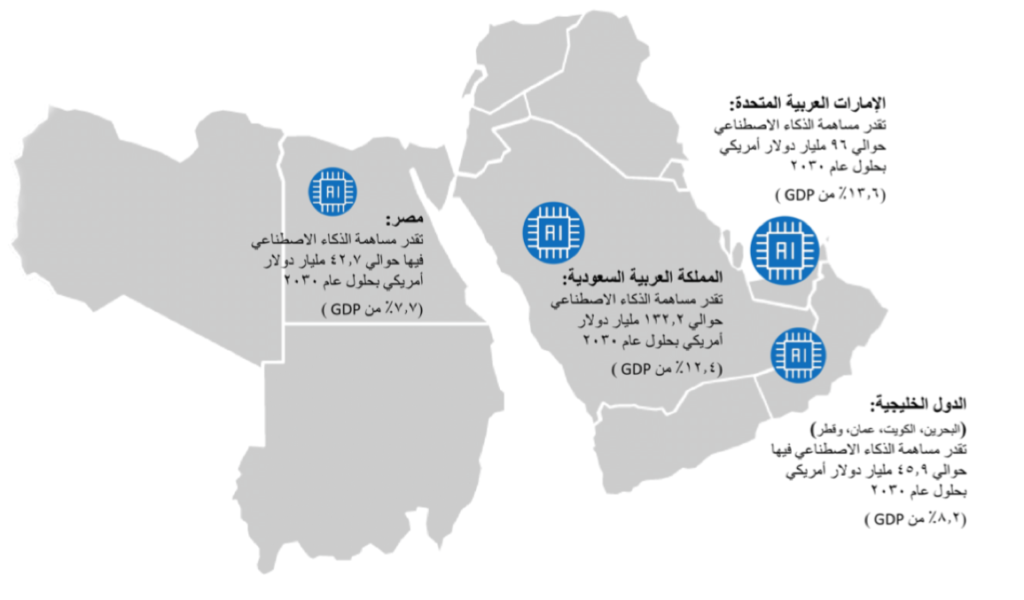

حوكمة الذكاء الاصطناعي في المملكة العربية السعودية

تتطلب تحديات الذكاء الاصطناعي حلولًا وأفكارًا مبتكرة، ليس في الجانب التقني فقط، ولكن أيضًا في الجانب التشريعي. ولهذا نُفذت تجربة رائدة في المملكة العربية السعودية لتطوير وتقديم مجموعة متكاملة من المقترحات والتوصيات تحت إطار تقرير يحمل عنوان “حوكمة الذكاء الاصطناعي“، والذي أعده الباحث في الذكاء الاصطناعي الدكتور إبراهيم المسلم. يوضّح الدكتور المسلم أن الحوكمة هي “رسم السياسات، وتحديد المسؤوليات والصلاحيات، التي تضمن تطوير واستخدام تقنيات الذكاء الاصطناعي بطريقة آمنة وأخلاقية ومتوافقة مع قيم المجتمع”.

سلّط التقرير الضوء على المخاطر المحتملة التي قد تنجم عن تبنّي تقنية الذكاء الاصطناعي في المجتمع، وقدّم العديد من التوصيات والحلول التشريعية لتفاديها. المخاطر التي ناقشها التقرير ليست مخاطر قد تحدث على المدى البعيد أو مخاطر قد تحدث، ولكن احتمال حدوثها ضئيل، بل هي مخاطر قد تحدث في أي لحظة، وواردة للغاية، ويجب أن تؤخذ في منتهى الجدية وإلا سوف تكون العواقب وخيمة، خصوصا إذا تم الاعتماد على تقنيات الذكاء الاصطناعي دون أي ضوابط أو معايير.

يقول التقرير أن لأنظمة الذكاء الاصطناعي دورة حياة، تبدأ بالولادة في المعامل والمختبرات، ثم تصل لفتوتها وعنفوانها عند تطبيقها وتبنيها في القطاعات الحكومية، ثم ترد إلى أراذل العمر حين تصبح مشاعا، ويتم تبنيها على نطاق واسع بين كل فئات وقطاعات المجتمع. في كل مرحلة من هذه المراحل يشكّل الذكاء الاصطناعي تحدياً بالغ الصعوبة، سواء للمطور أو المستخدم أو حتى صانع القرار.

معضلة الصندوق الأسود

يؤسس التقرير في بدايته للمعضلة الأساسية التي قد تنجم منها بقية المخاطر، والتي تكشف مدى صعوبة ترويض الذكاء الاصطناعي. ففي خلال مرحلة بناء نظام ذكاء اصطناعي يمكن للمطورين أن يراقبوا البيانات التي يتم تغذيتها في النظام، ويمكن لهم أيضا أن يتابعوا النتائج التي تظهر منه. حتى الآن كل شيء يبدو طبيعياً، لكن ما هو غير طبيعي أن مطوري النظام لا يستطيعون أن يفسروا لماذا ظهرت نتائج معينة دون غيرها. في هذه الحالة يصير النظام مثل الصندوق الأسود، حيث يمكنك رؤية المدخلات والمخرجات، لكن لا يمكنك رؤية ما يحدث بينهما بالداخل، وهذا يؤدي إلى صعوبة اكتشاف الأخطاء، وصعوبة تصحيحها وتلافي تكراراها في حال اكتشافها. ولهذا السبب تحديداً تسمى هذه المعضلة بــ “معضلة الصندوق الأسود”.

هذا المأزق سببه أن نظام الذكاء الاصطناعي يتم بناؤه بطريقة غير خطية، فهو ليس مجموعة من الأوامر المتتالية التي تنفذ مهام محددة. نظام الذكاء الاصطناعي الحديث عبارة عن نظام شبكي مشابه لدماغ الإنسان (يسمى شبكة عصبونية) يتم تغذيته بالبيانات، ومن ثم يتعلم من تلقاء نفسه، وبالتالي، قد يتعلم بطريقة خاطئة، أو قد يتعلم أشياء أخرى لم نقصد تعليمه إياها من الأساس.

لنأخذ مثالا حقيقياً، في أثناء إعداد دراسة عن حالات التحرش في الجامعات استعان باحث بـ ChatGPT، فذكر له حالة تحرش قام بها دكتور في كلية الحقوق، وأكد إجابته بذكر مصدره، وكان مقال من صحيفة واشنطن بوست. الكارثة إن اسم الدكتور حقيقي، ولكن المرجع المذكور والحالة بأجمعها ملفقة ولم تحدث. لماذا لفّق النظام هذه الإجابة؟ لا أحد يعرف. حتى المطورين في شركة OpenAI لا يعرفون. فالنظام لغز تقني، نظام معقد يعالج كميات كبيرة من البيانات، وينتج نتائج صعبة الفهم أو التفسير، مما يجعلنا نتعجب من قدراته ولكن في نفس الوقت نشكك في موثوقيتها.

التقرير لم يقتصر على توضيح المخاطر التقنية، بل تناول المخاطر الأمنية، مثل أتمتة الهجمات السيبرانية، وأتمتة حملات التصيد الإلكتروني التي تؤدي إلى الاستيلاء على البيانات الشخصية، واختراق الأنظمة، كما تناول مخاطر اجتماعية، مثل تلفيق مقاطع الفيديو ونشر الأخبار المزيفة لتجييش والتحكم بالرأي العام، وأيضا مخاطر نفسية من أشهرها ما يعرف بتشوّه السناب شات، وهو حالة نفسية يتناقص خلالها احترام وتقدير الذات بسبب الاستخدام الزائد لفلاتر تعديل ملامح الوجه المدعمة بالذكاء الاصطناعي في شبكات التواصل الاجتماعي.

كمهتم في المجال التربوي شدني تأكيد التقرير على أحد أهم مخاطر الذكاء الاصطناعي في التعليم حيث أكد أنه “مع الحاجة إلى زيادة التركيز على علوم الحاسب في النظام التعليمي لتأهيل الطلاب لسوق العمل، ومع ضيق الوقت الدراسي، فإن المناهج الدراسية ستشهد انخفاضاً في مواد وعلوم أخرى كالفنون والعلوم الإنسانية التي لها ارتباط وثيق بالتفكير الإبداعي والتواصل والقدرة على التعبير، وهذا سيكون له تأثير معاكس في تنشئة الأطفال، وسيضعف قدرتهم على التركيز بشكل خاص، وقدراتهم الإدراكية والفكرية بشكل عام.”

الدرس الذي يجب أن نتعلمه من شتاء الذكاء الاصطناعي هو ألا نسوّق له من خلال الاندفاع في المبالغة والتهويل والتضخيم، كما يجب أيضاً ألا نندفع في تطويره دون أي تمعّن في العواقب والاحتمالات الوخيمة، وهو للأسف ما استشرى مؤخراً بين الشركات المطورة له. يفترض بكل مهتم ومختص بالذكاء الاصطناعي أن يبادر إلى توضيح إشكالياته وتحدياته، وأن يؤكد أن تطويره يحتاج وقتاً وصبراً وتوخياً وتقييماً مستمرا لمخاطرة ..

.. حينها سيزهر ربيع الذكاء الاصطناعي.

2 تعليقات

ما شاء الله أسلوب متسلسل ومعلومات قيمة

عرض جميل جدا 20 علا 20